AI Act چیست؟ AI Act اولین چارچوب قانونی در زمینه هوش مصنوعی است که به ریسکهای حوزه هوش مصنوعی میپردازد.

هدف AI Act چیست؟ هدف آن ارائه الزامات و تعهداتی روشن و شفاف به توسعهدهندگان هوش مصنوعی در خصوص کاربردهای خاص هوش مصنوعی است. در عین حال، این مقررات بهدنبال کاهش بار اداری و مالی برای مشاغل، به ویژه شرکتهای کوچک و متوسط یا SMEs میباشد.

AI Act بخشی از مجموعه گستردهتری از اقدامات سیاستی برای حمایت از توسعه هوش مصنوعی مطمئن است که AI Innovation Package و Coordinated Plan on AI را هم شامل میشود. مجموعه این اقدامات ایمنی و حقوق اساسی مردم و مشاغل را در ارتباط با هوش مصنوعی تضمین میکند. این اقدامات همچنین فرآیندهای پذیرش هوش مصنوعی، سرمایهگذاری و نوآوری در آن را در سراسر اتحادیه اروپا تقویت خواهند کرد.

AI Act اولین چارچوب قانونی جامع هوش مصنوعی در سراسر جهان است. هدف از این قوانین جدید، تقویت هوش مصنوعی مطمئن در اروپا و فراتر از آن است. برای رسیدن به این هدف، اطمینان حاصل میشود که سیستمهای هوش مصنوعی به حقوق اساسی، ایمنی و اصول اخلاقی احترام میگذارند و همچنین به ریسکهای مدلهای بسیار قدرتمند و تاثیرگذار AI پرداخته میشود.

معرفی هفت نوع هوش مصنوعی و اهمیت آنها در زندگی

ویدیوهای بیشتر درباره هوش مصنوعی

چرا به قوانینی در حوزه AI نیاز است؟

AI Act تضمین میکند که کاربران میتوانند به دستاوردهای هوش مصنوعی اتکا کنند. با این که بیشتر سیستمهای هوش مصنوعی هیچگونه ریسکی ندارند و میتوانند به حل بسیاری از چالشهای اجتماعی کمک کنند، برخی از سیستمهای خاص هوش مصنوعی ریسکهایی ایجاد میکنند که ما باید برای جلوگیری از نتایج نامطلوب باید به آنها بپردازیم.

مثلاً بیشتر مواقع نمیتوان پی برد که چرا سیستم هوش مصنوعی تصمیم خاصی گرفته یا پدیده ویژهای را پیشبینی کرده و اقدام خاصی در این خصوص انجام داده است. بنابراین، مثلاً در تصمیمگیری برای استخدام یا در یک طرح عمومی تأمین مزایا، بهراحتی نمیتوان ارزیابی کرد که آیا فردی بهطور ناعادلانه متضرر شده است یا خیر.

با این که قوانین موجود محافظتهایی فراهم میکنند، برای پرداختن به چالشهای خاصی که سیستمهای هوش مصنوعی ممکن است ایجاد کنند، کافی نیستند.

برای مشاوره رایگان و یا طراحی و اجرای زیرساخت شبکه و SDWAN با کارشناسان شرکت APK تماس بگیرید. |

قوانین پیشنهادی AI Act چیست

- به ریسکها، بهویژه آن دسته از ریسکهایی رسیدگی میکنند که برنامههای کاربردی هوش مصنوعی ایجاد میکنند؛

- جلوی آن دسته از فعالیتهای هوش مصنوعی را که ریسکهایی غیرقابلقبول ایجاد میکنند، میگیرند؛

- فهرستی از برنامههای پرریسک ایجاد میکنند؛

- برای سیستمهای هوش مصنوعی الزامات روشنی بهمنظور پرداختن به برنامههای کاربردی پرخطر تعیین میکنند؛

- تعهدات خاص توسعهدهندگان و ارائهدهندگان برنامههای کاربردی پرریسک هوش مصنوعی را تعریف میکنند؛

- قبل از راهاندازی یک سیستم هوش مصنوعی خاص یا عرضه آن در بازار، درخواست ارزیابی انطباق [با قوانین و مقررات مربوط] میدهند؛

- پس از عرضه یک سیستم هوش مصنوعی معین به بازار، قوانین و مقررات مربوط به آن را اعمال و اجرا میکنند؛

- ساختاری حکومتی در سطح اروپا و سطح ملی ایجاد میکنند؛

بیشتر بخوانید: بررسی چارچوب های AI و انواع برتر آن در سال 2024

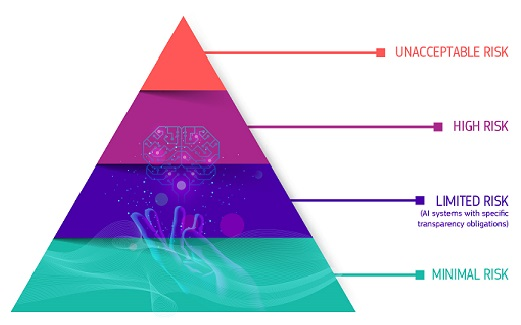

رویکرد مبتنی بر ریسک

Regulatory Framework یا چارچوب نظارتی، ریسک را در 4 سطح برای سیستمهای هوش مصنوعی تعریف میکند:

تمام سیستمهای هوش مصنوعی که تهدیدی آشکار برای ایمنی، معیشت و حقوق مردم تلقی میشوند، از امتیازدهی اجتماعی از جانب دولتها گرفته تا اسباببازیهایی که از دستیار صوتی استفاده میکنند و افراد را به رفتارهای پرخطر تشویق میکنند، ممنوع خواهند شد.

سیستمهای هوش مصنوعی پرریسک

سیستمهای هوش مصنوعی که در طبقهبندی «پرریسکها» قرار میگیرند، شامل فناوری هوش مصنوعیای است که در موارد زیر استفاده میشود:

- زیرساخت های حیاتی مانند حمل و نقل، که ممکن است زندگی و سلامت شهروندان را در معرض خطر قرار دهد؛

- آموزش تحصیلی یا حرفهای، که ممکن است دستیابی به امکانات تحصیلی و دوره حرفهای زندگی یک فرد را تعیین کند، مثل نمرهدهی در امتحانات؛

- بخشهایی از محصولات که بهمنظور اطمینان از ایمنی و جلوگیری از خطرات و آسیبها طراحی شدهاند. مثل کاربرد هوش مصنوعی در جراحی با کمک ربات.

- استخدام، مدیریت کارگران و دسترسی به خوداشتغالی مانند نرمافزار مرتبسازی CV برای فرآیندهای استخدام.

- خدمات ضروری Public و Private مانند امتیازدهی اعتباری که شهروندان را از فرصت دریافت وام محروم میکند.

- اجرای قوانینی که ممکن است با حقوق اساسی مردم تداخل داشته باشد مثل ارزیابی اطمینانپذیری شواهد.

- مهاجرت، پناهندگی و مدیریت کنترل مرزی مانند بررسی خودکار درخواستهای ویزا.

- اجرای عدالت و فرآیندهای دموکراتیک مانند راهکارهای های هوش مصنوعی برای جستجوی احکام دادگاه.

بیشتر بخوانید: مزیت AI در کاهش خطای انسانی در تجزیهوتحلیل داده

سیستمهای پرریسک هوش مصنوعی قبل از عرضه به بازار مشمول تعهدات سختگیرانه میشوند:

- داشتن سیستمهای مناسب و کافی ارزیابی و کاهش ریسک؛

- کیفیت بالای مجموعه دادههای تغذیهکننده سیستم برای به حداقل رساندن ریسکها و نتایج ناعادلانه و تبعیضآمیز؛

- ثبت فعالیت برای اطمینان از امکان ردیابی نتایج؛

- اسناد مفصلی که کلیه اطلاعات لازم درباره سیستم و هدف آن را برای مقامات جهت ارزیابی تطبیقپذیری آن ارائه میکند؛

- اطلاعات واضح و کافی برای پیادهسازی؛

- اقدامات نظارتی انسانی مناسب برای به حداقل رساندن ریسک؛

- سطح بالایی از استحکام، امنیت و صحت؛

تمام سیستمهای شناسایی بیومتریک Remote، پرریسک و مشمول الزامات سختگیرانه در نظر گرفته میشوند. استفاده از شناسایی بیومتریک Remote در فضاهای در دسترس عموم برای اهداف حوزه اجرای قانون اصولاً ممنوع است.

سیستمهای هوش مصنوعی با ریسک محدود

ممنظور از ریسک محدود، ریسکهای مرتبط با نبود شفافیت در استفاده از هوش مصنوعی است. AI Act تعهدات خاصی در خصوص شفافیت معرفی میکند تا اطمینان حاصل شود که افراد در صورت لزوم مطلع میشوند و باعث افزایش اعتماد میگردد. مثلاً افراد هنگام استفاده از سیستمهای هوش مصنوعی مانند رباتهای گفتگو باید آگاه باشند که در حال تعامل با یک ماشین هستند تا بتوانند آگاهانه تصمیم بگیرند که ادامه دهند یا کنار بکشند. ارائهدهندگان همچنین باید اطمینان حاصل کنند که محتوایی که هوش مصنوعی تولید کرده است، قابل شناسایی است. علاوه بر این، متنی که هوش مصنوعی که با هدف اطلاعرسانی به افراد درباره موضوعات موردعلاقه عموم منتشر میکند، باید با برچسب تولید مصنوعی شناسایی شود. این مورد همچنین در خصوص محتوای صوتی و تصویری ایجادکننده Deep Fake نیز صادق است.

انواع سیستمهای هوش مصنوعی با حداقل ریسک یا بدون ریسک با AI Act چیست

AI Act امکان استفاده رایگان از هوش مصنوعی با حداقل ریسک را فراهم میکند که شامل برنامههای کاربردیای مانند بازیهای ویدیویی با هوش مصنوعی یا فیلترهای Spam میشود. بخش اعظم سیستمهای هوش مصنوعی که در حال حاضر در اتحادیه اروپا استفاده میشوند در این دسته قرار میگیرند.

عملیسازی این موارد برای ارائهدهندگان سیستمهای پرخطر هوش مصنوعی به چه صورت است؟

عملیسازی این موارد برای ارائهدهندگان سیستمهای پرخطر هوش مصنوعی به چه صورت است؟

هنگامی که یک سیستم هوش مصنوعی وارد بازار میشود، مقامات مسئول نظارت بر بازار هستند، توسعهدهندگان از مانیتورینگ و نظارت انسانی اطمینان حاصل میکنند و ارائهدهندگان یک سیستم مانیتورینگ پس از فروش در اختیار خواهند داشت. ارائهدهندگان و توزیعکنندگان نیز حوادث جدی و مشکلات فنی را گزارش خواهند کرد.

راهکاری برای استفاده مطمئن از مدلهای بزرگ هوش مصنوعی

مدلهای همه منظوره هوش مصنوعی در سیری تصاعدی به اجزای سیستمهای هوش مصنوعی تبدیل خواهند شد. این مدلها میتوانند تعداد بیشماری از وظایف مختلف را انجام دهند و با آنها تطبیق یابند.

با این که مدلهای هوش مصنوعی همهمنظوره میتوانند امکان استفاده از راهکارهای AI بهتر و قدرتمندتری را فراهم کنند، نظارت بر همه قابلیتها دشوار خواهد بود.

تعهداتی برای ارائه شفافیت در مورد مدلهای عمومی هوش مصنوعی معرفی میکند تا فهم بهتری از این مدلها ایجاد شود. همچنین، این تعهدات میزان خطری را که مدلهای بسیار قدرتمند و مؤثر میتوانند ایجاد کنند، مدیریت میکنند. این تعهدات اضافی شامل خودارزیابی و کاهش ریسکهای سیستمی، گزارش حوادث جدی، انجام آزمایشها و ارزیابی مدلها و همچنین الزامات امنیت سایبری است.

قانونگذاری آیندهنگر

از آنجایی که هوش مصنوعی فناوریای است که بهسرعت در حال توسعه است، این طرح پیشنهادی دارای رویکردی آیندهنگر است که امکان تطبیق قوانین با تغییرات تکنولوژیک را فراهم میکند. برنامههای کاربردی هوش مصنوعی حتی پس از عرضه به بازار نیز باید همچنان قابل اعتماد باقی بمانند. این امر مستلزم این است که توسعهدهندگان بهطور مداوم کیفیت و ریسک را مدیریت کنند.

اجرا و پیادهسازی

هدف این هوش مصنوعی ایجاد محیطی است که در آن فناوریهای هوش مصنوعی به وقار، حقوق و اعتماد انسانها احترام بگذارد. همچنین همکاری، نوآوری و تحقیق در زمینه هوش مصنوعی را در بین ذینفعان مختلف تقویت میکند. علاوه بر این، با اذعان به نیاز به همسویی جهانی در اداره هوش مصنوعی، در گفتگو و همکاری بینالمللی در خصوص مسائل هوش مصنوعی شرکت میکند. دفتر هوش مصنوعی اروپا با این اقدامات تلاش میکند تا اروپا را پیشرو در توسعه اخلاقی و پایدار فناوریهای هوش مصنوعی قرار دهد.