در مورد ویژگی های vSphere 7 چه می توان گفت؟ NVMe به واسطه توان عملیاتی بالا و تاخیر کم روز به روز محبوبتر میشود و در همین حال، صنایع مختلف مانند هوش مصنوعی، یادگیری ماشینی و IT به توسعه خود ادامه داده و نیاز به عملکرد بهتر و بیشتر رو به افزایش است. معمولا تجهیزات NVMe با استفاده از PCIe Bus همواره Local هستند، بنابراین چگونه میتوان در یک Array خارجی از تجهیزات NVMe بهرهمند شد؟ صنایع جهت پیشرفت قابلیتهای اتصالات خارجی از NVMe over Fabrics استفاده کردهاند و این اتصالات یا مبتنی بر FC هستند یا IP. از آنجایی که اتصال معمولی به انداره کافی سریع نیست، الزاماتی به منظور حفظ بهره وری اتصالات خارجی NVMe لحاظ شدهاند.

نگاهی به VMware NVMeoF

VMware پشتیبانی ذخیرهسازی اشتراکی NVMe را با استفاده از NVMeoF به vSphere 7 اضافه نمود و برای اتصالات خارجی، NVMe over Fibre Channel و NVMe over RDMA یا RoCE v2 پشتیبانی میشوند. با NVMeoF، اهداف به عنوان Namespaceها نمایش داده میشوند که برای یک Host در Modeهای Active/Active یا Asymmetrical Access معادل SCSI LUNs هستند. این قابلیت به Hostهای ESXi اجاره میدهد تا Namespaceهای نمایش داده شده NVMe را یافته و از آنها استفاده کنند. ESXi اهداف NVMeoF را شبیهسازی نموده و در همین حین SCSI بصورت داخلی آنها را هدف گرفته و به عنوان اهداف Active/Active SCSI یا اهداف ضمنی SCSI ALUA نمایش میدهد.

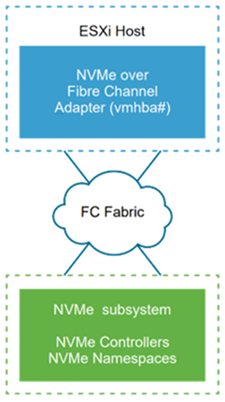

NVMe over Fibre Channel

این تکنولوژی NVMe را به پروتکل FC Map وارد نموده و انتقال دادهها و دستورات را میان کامپیوتر Host و تجهیزات ذخیرهساز هدف ممکن میسازد و این انتقال نیازمند یک زیرساخت FC است که از NVMe پشتیبانی نماید.

به منظور فعالسازی و دسترسی به ذخیرهساز NVMe over FC، باید در ESXi Host یک آداپتور FC نصب نمود که از NVMe پشتیبانی نماید و هیچ تنظیم خاصی برای آداپتور نیاز نیست زیرا بصورت خودکار به یک Subsystem مربوط به NVMe متصل شده و تمامی ذخیرهسازهای اشتراکی NVMe را پیدا میکند. ممکن است بعدها آداپتور را دوباره پیکربندی نموده و کنترلرهای آن را قطع کنیم یا کنترلرهای جدیدی متصل نماییم.

ویدیوی آموزشی مبانی اولیه مجازی سازی با VMware vSphere

ویدیوهای بیشتر درباره vSphere

الزامات NVMe over FC

- NVMe Array که از FC پشتیبانی نماید

- Host ESXi تطبیقپذیر vSphere 7

- کنترلر NVMe

منظور از NVMeoF over RDMA

این تکنولوژی از انتقال Remote Direct Memory Access یا RDMA میان دو سیستم در یک شبکه استفاده میکند که قابلیتهای تبادل دادههای حافظه، غیرفعال کردن سیستمهای عملیاتی یا پردازنده هر یک از سیستمها را فعال میکند. ESXi از RDMA over Converged Ethernet v2 یا RoCE v2 پشتیبانی میکند.

به منظور فعالسازی و دسترسی به NVMe با استفاده از RDMA ،ESXi Host از یک آداپتور RNIC در Host و یک آداپتور ذخیرهساز SW NVMe over RDMA استفاده میکند. باید هردو آداپتور را جهت استفاده برای بررسی ذخیرهساز NVMe تنظیم نمود.

پیشنیازهای تنظیمات NVMeoF

به هنگام تنظیم NVMeoF، اقدامات خاصی وجود دارند که باید صورت گیرند:

- جهت دسترسی به Namespace یکسان نباید انواع انتقال را ترکیب نمود.

- باید مطمئن شد که تمامی مسیرهای فعال به Host نمایش داده میشوند.

- NMP استفاده و پشتیبانی شده نیست و بجای آن HPP یا High-Performance Plugin برای اهداف NVMe مورد استفاده قرار میگیرد.

- اتصال اختصاصی Layer 3 یا Layer 2 VLAN

- محدودیتها:

- Namespaceهای -32

- مسیرها=128 (نهایتا 4 مسیر/Namespace در یک Host)

VMDK اشتراکی

VMDK اشتراکی در VMFS

در vSphere 7 ،VMware پشتیبای برای SCSI-3 Persistent Reservations یا SCSI-3 PR را در سطح دیسک مجازی VMDK اضافه نموده است. معنای این امر چیست؟ اکنون این قابلیت را داریم تا در VMFS و با استفاده از دیسکهای اشتراکی، یکWindows Server Failover Cluster یا WSFC را پیادهسازی کنیم.

با این حال این اقدام دیگری است که جهت کاهش الزامات RDMها برای سیستمهای کلاسترشده صورت گرفت. با HW پشتیبانی شده، اکنون میتوان پشتیبانی از دیسکهای مجازی کلاسترشده یا VMDK را در یک Datastore خاص فعال نمود و این امکان را فراهم میکند تا RDMهای خود را به VMFS انتقال داده و بسیاری از مزایای مجازیسازی که با RDM از دست دادهایم بازیابی کنیم.

بیشتر بخوانید: ارتقای ویژگی vMotion Storage در vSphere 7

VMDKهای اشتراکی در پیشنیازهای VMFS

- Array ما باید ATS ،SCSI-3 PR نوع Write Exclusive-All Registrant یا WEAR را پشیبانی کند

- تنها با Arrayهایی پشتیبانی میشود که از Fibre Channel یا FC برای اتصال استفاده میکنند.

- تنها Datastoreهای VMFS6

- تجهیزات ذخیرهساز باید با NMP Claim شوند. ESXi از Plug-inهای Third Party یا MPPs در تنظیم های کلاسترشده دیسک مجازی پشتیبانی نمیکند.

- VMDKها باید بصورت Eager Zeroed Thick یا EZT آمادهسازی شوند.

- VMDKهای کلاسترشده باید با Bus اشتراکی تنظیم شده روی حالت Physical به یک کنترلر مجازی SCSI ضمیمه گردند.

- یک قانون Anti-Affinity DRS جهت اطمینان از اینکه ماشینهای مجازی و Nodeهای WSFC در Hostهای جداگانه راهاندازی میشوند لازم است.

- تغییر/افزایش WSFC Parameter QuorumArbitrationTimeMax به 60

- Windows Server 2012R2/2016/2019. SQL Server 2016/2017 جهت تایید تنظیم مورد استفاده قرار گرفت.

- Boot Disk (و سایر دیسکهای غیر اشتراکی) باید به یک کنترلر مجازی SCSI جداگانه با Bus اشتراکی تنظیم شده روی حالت None ضمیمه شوند.

بیشتر بخوانید: معرفی ویژگیها و قابلیتهای جدید پلتفرم vSphere 7

- ترکیب دیسکهای کلاسترشده و غیر اشتراکی در یک کنترلر مجازی SCSI واحد پشتیبانی نمیشود.

- Datastore نمیتواند گسترش یافته یا چندین اندازه را Span کند.

- تمامی Hostها و vCenter باید vSphere 7 یا بالاتر باشند.

- ترکیب VMDKهای کلاستر شده و سایر انواع دیسک (vVolها و RDMها) پشتیبانی شده نیستند

- محدودیتها

- پشتیبانی برای بیش از 5 WSFC Node ( همانند یا RDM)

- 128 VMDK کلاسترشده در هر Host

- تنها Cluster across Box یا CaB پشتیبانی میشود و Cluster in a Box یا CiB تحت پشتیبانی نیست

ویژگیهای vSphere

- ویژگیهای پشتیبانی شده:

- vMotion برای Hostهای پشتیبانیشده الزامات یکسانی را فراهم میکند

- ویژگیهای پشتیبانی نشده:

- Snapshotها، Cloneکردن و Storage vMotion

- Fault Tolerance یا FT

- تغییر Hot به VM HW یا افزونه Hot دیسکهای کلاستر شده

فعالسازی VMDK کلاستر شده

زمانی که به Datastore پشتیبانی شده میرویم، زیر Tab Configure یک قابلیت جدید برای فعالسازی VMDK مشادهد می شود و اگر قصد پیادهسازی یک Microsoft WSFC یا انتقال به آن را با استفاده از دیسکهای اشتراکی داریم، پس باید این قابلیت را فعال سازیم. زمانی که این قابلیت فعال شود، میتوان مطالب Setup for Windows Server Failover Clustering را مطالع نمود تا WSFC خود را در Datastore VMFS6 پیادهسازی کرد.

- Demo و جزئیات انتقال WSFC با استفاده از RDMها به VMDKهای اشتراکی در VMFS

- انتقال vSphere 7 WSFC RDM به VMDKهای اشتراکی

- فعالسازی VMDKهای کلاستر شده

- فعالسازی پشتیبانی VMDKهای اشتراکی در Datastoreهای VMFS